La User Interface del futuro

L’intelligenza artificiale che reagisce alle emozioni

Avvalendosi dell’intelligenza artificiale, apparecchi e programmi impareranno a reagire alle emozioni dell’utente. Ciò trasformerà in modo drammatico la User Interface del futuro

testo: Hansjörg Honegger,

La funzionalità degli e-reader è fuori dubbio: leggeri, dotati di memoria per un numero illimitato di libri, alcuni addirittura permanentemente online. Quello che non possono fare è leggere e comprendere i testi – finora. Con l’ausilio dell’intelligenza artificiale e di metodi per l’analisi delle emozioni umane, gli e-reader saranno forse capaci in futuro di fare molto più:

- Le lettere si ingrandiranno automaticamente ai primi segni di affaticamento.

- Uno sguardo dubbioso che si arresta su una parola ne richiamerà la spiegazione o la traduzione.

- Se verrà meno la concentrazione, ecco che l’intero testo successivo sarà formulato in modo un po’ più semplice. Tutto questo affinché il lettore si soffermi il più a lungo possibile.

Certo, in parte si tratta ancora di un’utopia. Gli esperti di UX (“User Experience” ovvero l’esperienza dell’utente) sono comunque pervenuti alla conclusione che: oggigiorno non basta più presentare agli utenti un’interfaccia intuitiva fondata su standard conosciuti. L’aspettativa a livello emozionale di chi oggi utilizza un apparecchio muta infatti continuamente. L’interfaccia utente deve in futuro tenere conto di queste aspettative. Indipendentemente da tutto ciò, i dispositivi wearable richiedono ad esempio spesso un tipo completamente nuovo di interfaccia utente. E la lingua non è affatto l’ultima risorsa.

Come prevenire le delusioni

Nello studio «The Experience Revolution: Digital Disappointment – Why Some Consumers Aren’t Fans» IBM constata che il 70 per cento dei clienti di offerte digitali è insoddisfatto. La delusione che molti provano nella realtà virtuale o nel comando vocale automatico, li trattiene dal confidare nel marchio una seconda volta. Per il successo di un marchio sono decisivi comodità, risultati rapidi e processi semplici, nonché, naturalmente, prezzi allettanti.

Si parla di delusione quando non si sono potute soddisfare le aspettative. Ma come può un apparecchio riconoscere un’aspettativa che dipende, non da ultimo, dallo stato d’animo del cliente? Il professor Per Bergamin, direttore dell’Institute for Research in Open-, Distance- and eLearning (IFeL) a Briga, si dedica da anni a questo problema. L’obiettivo della sua unità di ricerca “Apprendimento personalizzato e adattivo” è quello di consentire agli studenti un apprendimento su misura tramite video a schermo. “Con la nostra soluzione, il grado di difficoltà della materia viene adeguato automaticamente in base al progresso di apprendimento dello studente”, spiega Bergamin. Il sistema in background impara ininterrottamente ed è in grado di interpretare il livello di conoscenze dello studente partendo dalle sue risposte. Sulla base di ciò viene presentata la materia successiva.

Bergamin fa un semplice esempio: “Il software può domandare come funziona l’evaporazione del ghiaccio. Oppure può ripartire la domanda in dieci singole domande che guidino lentamente lo studente alla soluzione esatta.” Secondo Bergamin, finora sono stati ottenuti i progressi di apprendimento con domande appropriate. Un processo faticoso, che richiede molto lavoro manuale da parte degli sviluppatori. Ora invece, nella fase 2, il principio con cui opera il team di ricerca di Briga include anche le emozioni umane. “Ci sono persone che non rispondono volentieri alle domande e questi studenti non devono essere svantaggiati”, sottolinea Bergamin. Le espressioni sul volto degli studenti devono informare sul loro livello di conoscenze. Guarda in modo interrogativo, disperato, entusiasta? Il software interpreta questi sentimenti e mostra la materia corrispondente. Ovviamente si presuppone che lo studente disponga dell’hardware adeguato.

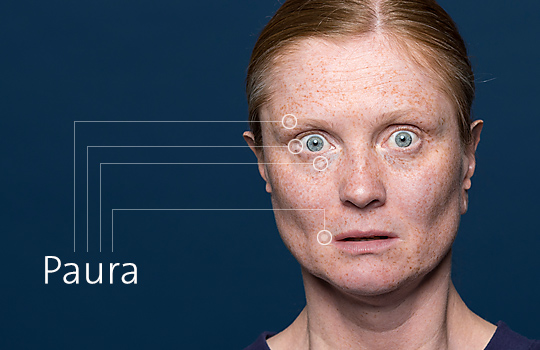

Sonar: più efficiente dei reporting di tipo classico

Ma, d’altra parte, è possibile che una macchina sia in grado di riconoscere sentimenti espressi da persone di culture differenti? Ciò non dovrebbe costituire alcun problema, purché il riconoscimento facciale si limiti ad esempio alle sette emozioni di base secondo Paul Ekmann. Le espressioni di gioia, rabbia, paura, disgusto, tristezza, sorpresa, disprezzo e vergogna sono innate nell’uomo e individuabili in tutto il mondo. Che la macchina interpreti correttamente l’espressione nel contesto adeguato, è tutt’altra cosa. La disperazione dello studente è dovuta al fatto che si trova a dover rispondere per la terza volta a questa stupida domanda o che anche alla terza volta non capisce la domanda?

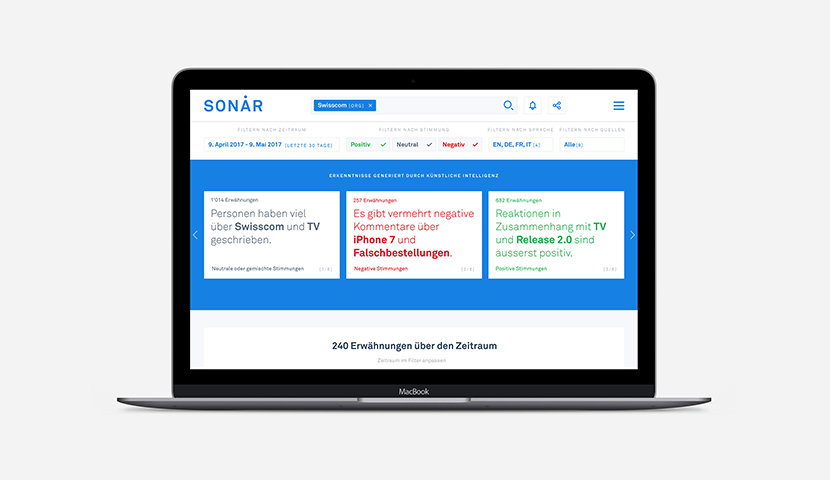

Il riconoscimento dei sentimenti umani non è sempre più importante solo per le interfacce utente, il suo significato cresce anche per lo sviluppo dei prodotti e il marketing. “Sonar”, una soluzione sviluppata da Swisscom, riconosce in tempo reale i sentimenti che nutrono i clienti nei confronti dell’azienda o dei prodotti e servizi di quest’ultima, oppure se da qualche parte in Svizzera si sta producendo qualcosa. “In una prova pilota analizziamo diversi canali pubblici internet”, spiega Marc Steffen, Head of Product Design, Artificial Intelligence & Machine Learning Group presso Swisscom. Non si tratta di per sé di una novità. Prima questi risultati venivano tuttavia riassunti in parte manualmente in reporting complicati e inoltrati ad alcune persone interessate: nel migliore dei casi in un dashboard, nel peggiore dei casi in un documento di testo.

Oggi, Sonar analizza in tempi reali lo stato d’animo dei clienti, mostra quanto è stato scritto e analizza simultaneamente se i trend sono positivi, negativi o neutrali. “Un product manager può cercare oggigiorno in Sonar un suo prodotto per appurare rapidamente se lo stato d’animo del cliente nei social media e nelle colonne di commento è piuttosto positivo o negativo e perché”, afferma Marc Steffen. Per arrivare a questo punto è stato tuttavia necessario analizzare inizialmente per il sistema circa 10.000 frasi e assegnare le formulazioni a uno stato. “Sonar impara in questo modo in contesti differenti quali sono le formulazioni positive e quali quelle negative.»

L’emozione determina il contenuto

L’interfaccia utente di domani non avrà più molto in comune con il modo in cui oggi utilizziamo e controlliamo programmi e informazioni. Saranno le aspettative dell’utente che determineranno in modo sempre più crescente quello che vedrà e come gli sarà presentato. Ciò diventerà possibile grazie all’intelligenza artificiale, che impara a interpretare le emozioni dell’utente – o del cliente – dalla voce, dal volto e dalla parola scritta. La cosa è comunque controversa: l’utente vuole davvero che il fornitore indaghi praticamente nei suoi pensieri?

Il professor Bergamin sottolinea che già oggi esistono sul mercato apparecchi relativamente convenienti, in grado di interpretare, tra l’altro, anche le attività del cervello. Per lui è comunque evidente che la massima priorità spetta all’autodeterminazione: “L’influsso del nostro software di apprendimento cala già oggi all’aumentare del livello conoscitivo di colui che apprende, perdendo la funzione di indirizzo e divenendo piuttosto uno strumento di supporto, ad esempio con informazioni supplementari di cui potrà, eventualmente, avvalersi.” I limiti di tutto questo devono ancora essere stabiliti. Per Marc Steffen di Swisscom non ci sono invece dubbi: “Qui occorre trasparenza assoluta e, in fin dei conti, anche la libertà di scelta dell’utente. Deve sapere sempre quello che fa il fornitore e poterlo in qualsiasi momento rifiutare.”

Ulteriori informazioni

Beware emotional robots: Giving feelings to artificial beings could backfire, study suggests: Proprio durante l’impiego di chatbot è decisivo il tipo di conversazione. Emozioni profonde da parte della macchina possono destare preoccupazioni.

Amazon Working on Making Alexa Recognize Your Emotions: Alexa deve riconoscere quando l’utente è arrabbiato e quindi scusarsi. Questa sarebbe una novità assoluta per i computer.

Sonar riconosce l’umore dei clienti

Sonar, un sistema sviluppato da Swisscom, raccoglie le opinioni dei clienti attraverso diversi canali, ad esempio da Twitter, dai commenti sui siti dei quotidiani, dai feed RSS o dal Service Desk. Contenuti positivi, negativi o neutri: Sonar analizza automaticamente l’umore. Inoltre il sistema riconosce le tendenze e gli argomenti o riassume i feedback dei clienti in poche frasi. Sonar permette di riconoscere come viene percepito il marchio da parte del cliente. E, sotto forma di chiara applicazione web, aiuta i collaboratori a comprendere meglio i clienti e a prender decisioni fondate su dati.

Maggiori informazioni