L’interface utilisateur de demain

L’intelligence artificielle réagit aux émotions

Grâce à l’intelligence artificielle, les appareils et les logiciels apprennent à réagir aux émotions des utilisateurs. Cela va révolutionner les interfaces utilisateur de demain.

Texte: Hansjörg Honegger,

Les liseuses électroniques sont très pratiques: légères, elles permettent d’enregistrer un grand nombre d’ouvrages dont certains sont en ligne de manière permanente. La seule chose que l’utilisateur doit encore faire lui-même, pour le moment, c’est de lire et de comprendre. Mais grâce à l’intelligence artificielle et aux méthodes d’analyse des émotions humaines, les liseuses électroniques auront sans doute bientôt d’autres compétences:

- la taille des caractères qui s’agrandit dès les premiers signes de fatigue du lecteur;

- l’affichage d’une explication, ou d’une traduction dès qu’un regard interrogateur est détecté;

- la reformulation automatique du texte dans un langage plus simple si le niveau de concentration diminue. Tout cela pour permettre à l’utilisateur de s’adonner plus longtemps à sa lecture.

C’est encore, du moins partiellement, de l’ordre de la science-fiction. Les spécialistes de l’UX («User Experience», l’expérience utilisateur) l’ont cependant bien compris: il ne suffit plus aujourd’hui de proposer aux utilisateurs une interface intuitive reposant sur des standards déjà bien connus. Les utilisateurs ont aujourd’hui des attentes émotionnelles en perpétuelle évolution vis-à-vis de leurs appareils. Les interfaces utilisateur devront à l’avenir être en mesure de répondre à ces attentes. Sans compter les wearables qui nécessitent souvent un type entièrement nouveau d’interface utilisateur. Et cela ne se limite certainement pas seulement au langage.

Ne pas décevoir

Dans l’étude «The Experience Revolution: Digital Disappointment – Why Some Consumers Aren’t Fans», IBM a constaté que 70% des utilisateurs de prestations numériques ne sont pas satisfaits. C’est la déception vis-à-vis de la réalité virtuelle ou de la commande vocale automatique qui les retient de s’adresser à nouveau à la marque. Le confort, la rapidité des résultats et des processus simples sont décisifs pour devenir fan d’une marque, sans oublier l’importance des prix intéressants, bien entendu.

Si l’utilisateur est déçu, c’est que ses attentes n’ont pas été remplies. Mais comment un appareil peut-il reconnaître les attentes d’un utilisateur, sachant que celles-ci dépendent aussi de son état émotionnel? Le Professeur Per Bergamin, directeur de l’Institut für Fernstudien und e-Learning-Forschung (IFeL) à Brigue, se penche depuis plusieurs années sur cette question. Son unité de recherche «Personalisiertes und adaptives Lernen» (Apprentissage personnalisé et adaptatif) s’est fixé pour objectif de permettre aux étudiants de profiter d’un apprentissage sur écran personnalisé. «Le niveau de difficulté des contenus d’apprentissage est automatiquement adapté en fonction des progrès réalisés par l’étudiant», explique Per Bergamin. En arrière-plan, le système apprend continuellement et est en mesure d’interpréter le niveau de connaissance en fonction des réponses données. Sur cette base, il adapte alors la suite des contenus d’apprentissage proposés.

Per Bergamin donne un exemple simple: «Le logiciel peut demander comment fonctionne l’évaporation de la glace. Ou il peut découper cette question en 10 questions séparées qui amèneront l’étudiant à trouver petit à petit la bonne solution.» Jusqu’à présent, explique-t-il, les progrès réalisés devaient être évalués à l’aide de questions correspondantes. Cela demandait au développeur beaucoup de travail manuel. Maintenant, en phase 2, l’équipe de chercheurs de Brigue travaille au développement d’une approche qui intègre les émotions humaines. «Certains étudiants n’aiment pas répondre à des questions. Il convient de ne pas les défavoriser», insiste Per Bergamin. On espère obtenir des informations à partir des expressions du visage de l’étudiant. A-t-il un air interrogatif, découragé ou enthousiaste? Le logiciel interprète ces sentiments et affiche des contenus adaptés. À condition, bien entendu, que l’étudiant dispose d’un matériel approprié.

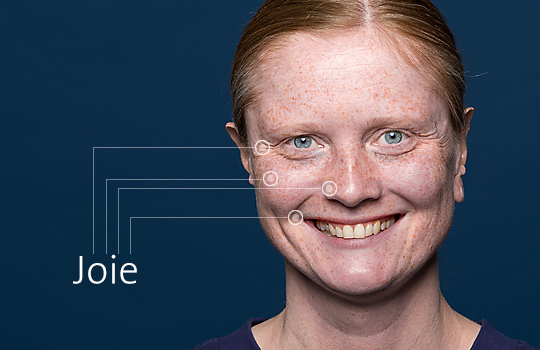

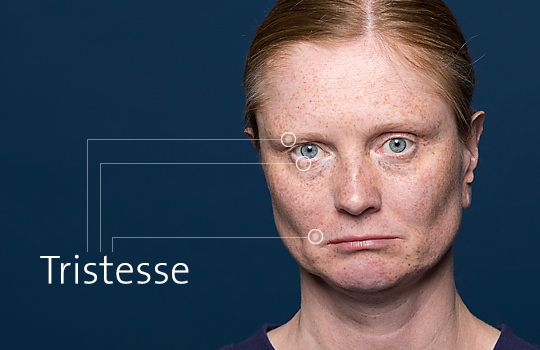

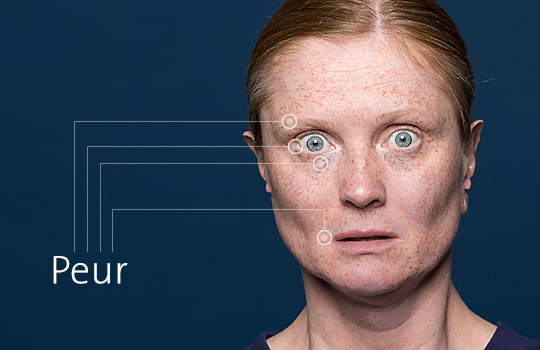

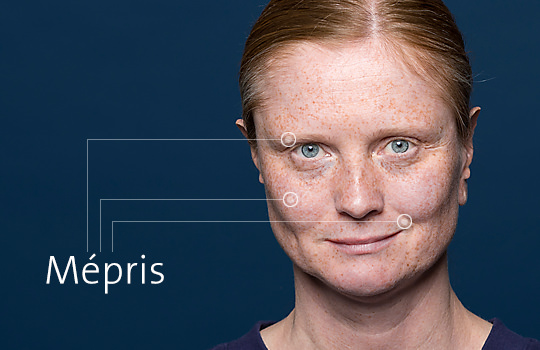

Sonar: plus efficace que le reporting classique

La question se pose cependant de savoir si les personnes issues de cultures différentes expriment leurs sentiments de telle sorte qu’une machine puisse les reconnaître. Tant que la reconnaissance faciale se limite, par exemple, aux sept émotions de base selon Paul Ekmann, cela ne devrait pas poser de problème. Les expressions du visage qui correspondent à la joie, à la colère, à la peur, au dégoût, à la tristesse, à la surprise, au mépris et à la honte sont innées et identifiables dans le monde entier. Rien ne permet cependant de garantir que la machine est capable d’interpréter ces expressions faciales en fonction du contexte. L’étudiant est-il découragé parce qu’il doit répondre pour la troisième fois à la même question idiote ou parce qu’il ne la comprend pas pour la troisième fois?

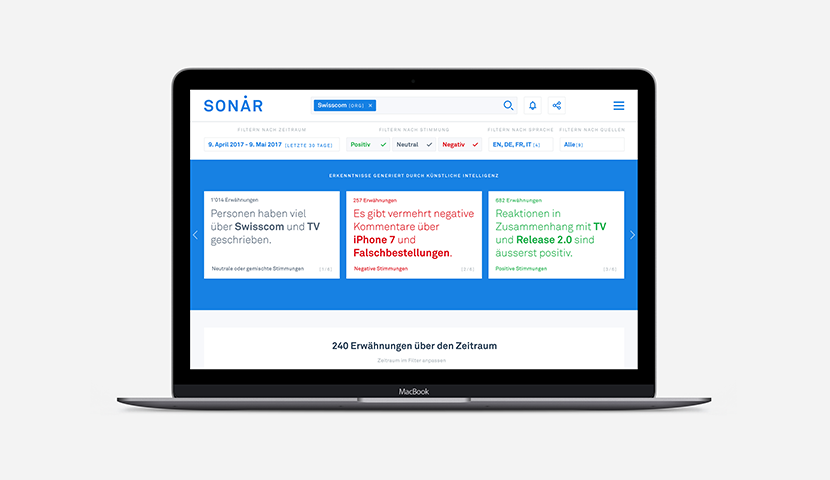

Reconnaître les sentiments est de plus en plus important, non seulement pour l’interface utilisateur, mais également pour le développement des produits et pour le marketing. «Sonar», une solution développée par Swisscom, détecte en temps réel les sentiments qu’éveillent chez les clients l’entreprise ou ses produits et prestations de service, et où, en Suisse, de nouvelles tendances sont en train de naître. «Dans le cadre d’un essai pilote, nous analysons différents canaux internet publics», explique Marc Steffen, Head of Product Design, Artificial Intelligence & Machine Learning Group chez Swisscom. Ce n’est pas nouveau en soi. Pourtant, jusqu’à présent, ces informations étaient compilées en partie manuellement au sein de reporting sophistiqués, et transmises à certaines personnes intéressées au mieux via un Dashboard, au pire via un document texte.

Dorénavant, Sonar analyse en temps réel l’état émotionnel des clients, affiche ce qui est écrit et analyse simultanément si les tendances sont positives, négatives ou neutres. «Un gestionnaire de produit peut à présent rechercher son produit au sein de Sonar et voir en un seul coup d’œil si l’appréciation de la clientèle dans les média sociaux et les commentaires est plutôt positive ou négative, et pourquoi il en est ainsi», selon Marc Steffen. Pour arriver à ce résultat, il a toutefois fallu analyser pour le système environ 10 000 enregistrements et affecter chaque formulation à un état d’esprit. «Sonar apprend ainsi si une formulation est positive ou négative en fonction des différents contextes.»

Les émotions déterminent le contenu

Les interfaces utilisateur de demain n’auront plus grand chose en commun avec la façon dont nous utilisons et commandons actuellement les programmes et les informations. Les attentes des utilisateurs auront de plus en plus d’influence sur les contenus et leurs modes de présentation. Et ce, grâce à l’intelligence artificielle qui apprend à reconnaître les émotions des utilisateurs en fonction de leur voix, de leur visage et des textes qu’ils écrivent. La question suivante va bien sûr se poser: l’utilisateur souhaite-t-il vraiment que l’opérateur analyse tout ce qui lui passe par la tête?

Per Bergamin explique que des appareils capables d’interpréter l’activité cérébrale sont d’ores et déjà disponibles sur le marché pour un prix relativement modeste. Cependant, il insiste sur le fait que la priorité absolue doit être accordée à l’autodétermination: «l’impact de nos logiciels d’apprentissage diminue déjà aujourd’hui proportionnellement au niveau de connaissances des apprenants. D’instructif, leur rôle vise alors de plus en plus à soutenir l’apprenant, p. ex. avec des informations supplémentaires qu’il peut utiliser si besoin est.» Reste à définir où la limite doit être fixée. Pour Marc Steffen de Swisscom, c’est pourtant très clair: «une transparence absolue est indispensable, au même titre que la liberté de choix de l’utilisateur. Il doit savoir à tout moment ce que l’opérateur fait et toujours avoir la possibilité de refuser.»

Informations complémentaires

Beware emotional robots: Giving feelings to artificial beings could backfire, study suggests: dans le cas de l’utilisation de Chatbots notamment, le type de conversation est décisif. Les émotions profondes du côté de la machine ont un effet dérangeant.

Amazon Working on Making Alexa Recognize Your Emotions: Alexa est censée reconnaître quand l’utilisateur est contrarié et s’excuser auprès de lui. Ce qui serait une véritable nouveauté pour un ordinateur!

Sonar détecte les humeurs des clients

Sonar, un système développé par Swisscom, collecte les données des clients par le biais de différents canaux comme Twitter, les commentaires laissés sur les sites internet des journaux, les flux RSS, ou le Service Desk. Que les contenus soient positifs, négatifs ou neutres – Sonar analyse automatiquement l’humeur du rédacteur. Le système reconnaît en outre les différents thèmes et tendances ou résume les feedbacks des clients en quelques phrases. Sonar permet de détecter la manière dont le client expérimente la marque. Cette application web très claire aide les collaborateurs à mieux comprendre la clientèle et à prendre des décisions en s’appuyant sur les données.